Qlik Cloud データフローを使ってETL処理を実現する方法を探る。

目次

こんにちはLioです。最近Qlik Cloudでデータフローという機能が公開されました。

ETL処理をノーコードで実施できるというもので、これを使えば技術者でなくともExcelなどでデータ利活用してきた経験があればある程度のデータ加工ができるようになると思います。(データフローとは)

そこでデータフローの実力をはかるべく、今回は実際にPreppinDataの課題をもとにデータフローを試してみました。

※過去にKNIMEでも同じことをしております。(KNIME触ってみた)

Qlik Cloud データフローの基本とその利点

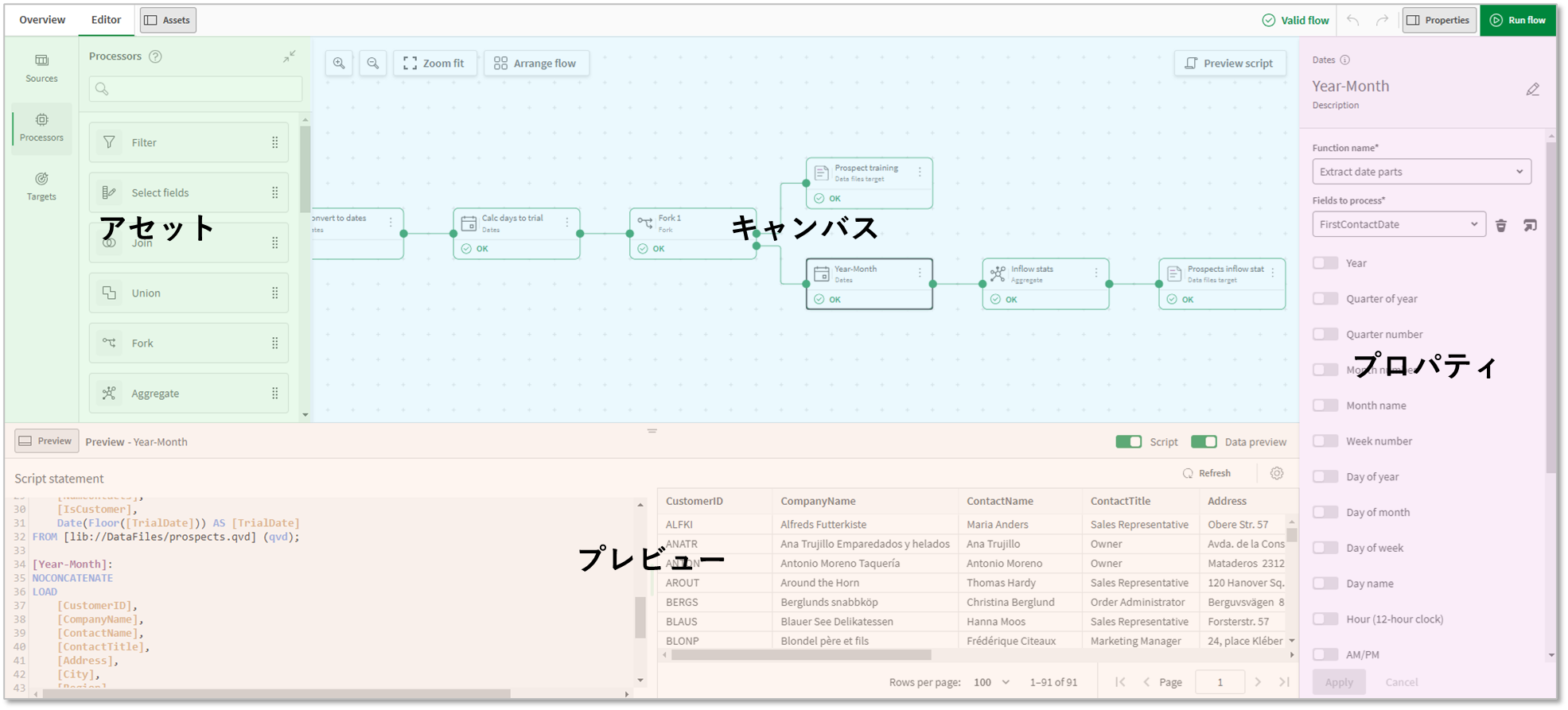

Qlik Cloud データフローは、データの抽出、変換、ロード(ETL)プロセスを効率的に行うための強力なツールです。このツールを使用することで、データの取り込みから分析までを一元的に管理でき、データの整合性と品質を確保しながら作業を進めることが可能です。

特にQlik Cloud データフローの利点としては、データ処理の中間レビューが可能である点、QlikSenseと同じスクリプトが生成され確認できる点、そしてユーザーフレンドリーなインターフェースを備えている点が挙げられます。これにより、技術的な専門知識がなくてもデータフローの設計と管理が容易になります。

Qlik Cloud データフローを使ったETL処理の具体例

実際にQlik Cloud データフローを使ってETL処理を行う具体例を見てみましょう。まず、データソースから必要なデータを抽出します。このデータソースは、データベース、クラウドストレージ、スプレッドシートなど様々な形式が利用可能です。

次に、抽出したデータを変換します。データのクレンジング、フィルタリング、集計などの処理を行い、分析に適した形式に整えます。最後に、変換したデータをターゲットのデータウェアハウスやデータベースにロードします。これにより、統合されたデータセットを用いて高度な分析が可能となります。

データ分析での活用事例を考える

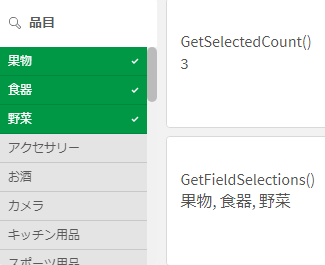

データ分析を行う上でデータの正確さやデータモデルは重要な要素です。その重要な要素である正確さやモデルを構築する際に起こりうる課題として、データ分析からアクションにつなげる人間とETL処理を行う人間は必ずしもイコールでないということが多々あります。データ分析基盤の中にETL処理機能が組み込まれたことで、よりデータの準備における敷居が下がってくるのではないかと思います。QlikはセルフBIとして誕生しましたが、さらに特別な技能がなくともデータ分析が行えるユーザーライクな進化を遂げていました。